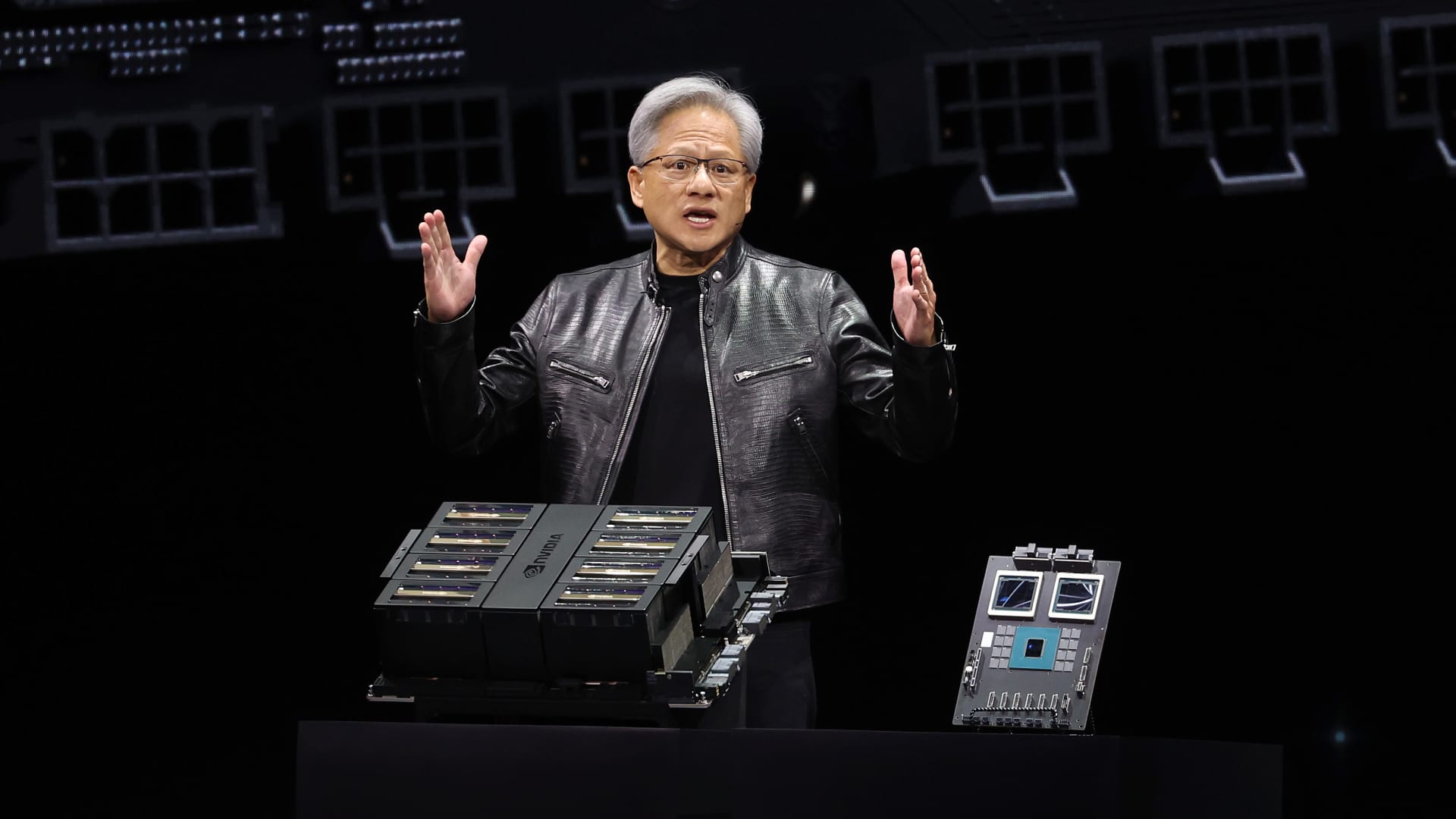

El CEO de Nvidia, Jensen Huang, pronuncia un discurso principal durante la Conferencia de Inteligencia Artificial GTC de Nvidia en el SAP Center el 18 de marzo de 2024 en San José, California.

Justin Sullivan | Getty Images

Nvidia anunció el lunes una nueva generación de chips y software de inteligencia artificial para ejecutar modelos de inteligencia artificial. El anuncio, realizado durante la conferencia de desarrolladores de Nvidia en San José, llega en un momento en que el fabricante de chips busca consolidar su posición como el proveedor preferido para empresas de inteligencia artificial.

El precio de las acciones de Nvidia ha aumentado cinco veces y las ventas totales se han más que triplicado desde que ChatGPT de OpenAI desató el auge de la inteligencia artificial a finales de 2022. Las GPUs de servidor de alta gama de Nvidia son esenciales para entrenar y desplegar grandes modelos de IA. Empresas como Microsoft y Meta han gastado miles de millones de dólares comprando los chips.

La nueva generación de procesadores gráficos de IA se llama Blackwell. El primer chip Blackwell se llama GB200 y se lanzará más adelante este año. Nvidia está seduciendo a sus clientes con chips más potentes para impulsar nuevos pedidos. Empresas y creadores de software, por ejemplo, todavía están luchando por conseguir la generación actual de chips “Hopper” H100 y similares.

“Hopper es fantástico, pero necesitamos GPUs más grandes”, dijo el CEO de Nvidia, Jensen Huang, el lunes en la conferencia de desarrolladores de la empresa en California.

Las acciones de Nvidia cayeron más del 1% en las operaciones extendidas el lunes.

La compañía también presentó un software generador de ingresos llamado NIM que facilitará la implementación de la IA, brindando a los clientes otra razón para quedarse con los chips de Nvidia sobre un campo creciente de competidores.

Los ejecutivos de Nvidia afirman que la compañía está pasando de ser un proveedor de chips mercenario a ser un proveedor de plataforma, como Microsoft o Apple, en la que otras empresas pueden construir software.

“Blackwell no es solo un chip, es el nombre de una plataforma”, dijo Huang.

“El producto comercializable era la GPU y el software era todo para ayudar a las personas a usar la GPU de diferentes maneras,” dijo el vicepresidente de empresas de Nvidia Manuvir Das en una entrevista. “Por supuesto, todavía hacemos eso. Pero lo que realmente ha cambiado es que ahora tenemos un negocio de software comercial.”

Das dijo que el nuevo software de Nvidia facilitará la ejecución de programas en cualquiera de las GPU de Nvidia, incluso en las más antiguas que podrían ser más adecuadas para implementar pero no para construir IA.

“Si eres un desarrollador y tienes un modelo interesante que quieres que la gente adopte, si lo colocas en un NIM, nos aseguraremos de que sea ejecutable en todas nuestras GPU, para que llegues a mucha gente,” dijo Das.

Conoce a Blackwell, el sucesor de Hopper

El superchip GB200 Grace Blackwell de Nvidia, con dos procesadores gráficos B200 y un procesador central basado en Arm.

Cada dos años Nvidia actualiza su arquitectura de GPU, logrando un gran salto en rendimiento. Muchos de los modelos de IA lanzados en el último año fueron entrenados en la arquitectura Hopper de la empresa, utilizada por chips como el H100, que fue anunciado en 2022.

Nvidia dice que los procesadores basados en Blackwell, como el GB200, ofrecen una gran mejora de rendimiento para empresas de IA, con 20 petaflops en rendimiento de IA frente a los 4 petaflops del H100. La potencia adicional de procesamiento permitirá a las empresas de IA entrenar modelos más grandes y complejos, dijo Nvidia.

El chip incluye lo que Nvidia llama un “motor transformador construido específicamente para ejecutar IA basada en transformers, una de las tecnologías clave que subyacen a ChatGPT.

La GPU Blackwell es grande y combina dos matrices fabricadas separadamente en un solo chip fabricado por TSMC. También estará disponible como un servidor completo llamado GB200 NVLink 2, que combina 72 GPUs Blackwell y otras partes de Nvidia diseñadas para entrenar modelos de IA.

El CEO de Nvidia, Jensen Huang, compara el tamaño del nuevo chip “Blackwell” con el actual chip “Hopper” H100 en la conferencia de desarrolladores de la compañía, en San José, California.

Nvidia

Amazon, Google, Microsoft y Oracle venderán acceso al GB200 a través de servicios en la nube. El GB200 combina dos GPUs Blackwell B200 con una CPU Grace basada en Arm. Nvidia dijo que Amazon Web Services construirá un clúster de servidores con 20,000 chips GB200.

Nvidia dijo que el sistema puede desplegar un modelo de 27 billones de parámetros. Eso es mucho más grande que incluso los modelos más grandes, como GPT-4, que supuestamente tiene 1.7 billones de parámetros. Muchos investigadores de inteligencia artificial creen que modelos más grandes con más parámetros y datos podrían desbloquear nuevas capacidades.

Nvidia no proporcionó un costo para el nuevo GB200 o los sistemas en los que se utiliza. Según estimaciones de analistas, el H100 basado en Hopper de Nvidia cuesta entre $25,000 y $40,000 por chip, con sistemas completos que cuestan hasta $200,000.

Nvidia también venderá procesadores gráficos B200 como parte de un sistema completo que ocupa un rack de servidor completo.

Servicio de inferencia de Nvidia

Nvidia también anunció que está agregando un nuevo producto llamado NIM, que significa Nvidia Inference Microservice, a su suscripción de software empresarial de Nvidia.

NIM facilita el uso de las GPUs antiguas de Nvidia para la inferencia, o el proceso de ejecutar software de IA, y permitirá a las empresas seguir utilizando los cientos de millones de GPUs de Nvidia que ya poseen. La inferencia requiere menos potencia computacional que el entrenamiento inicial de un nuevo modelo de IA. NIM permite a las empresas que desean ejecutar sus propios modelos de IA, en lugar de comprar acceso a resultados de IA como servicio de empresas como OpenAI.

La estrategia es que los clientes que compren servidores basados en Nvidia se inscriban en Nvidia enterprise, que cuesta $4,500 por GPU por año por una licencia.

Nvidia trabajará con empresas de IA como Microsoft o Hugging Face para asegurarse de que sus modelos de IA estén ajustados para ejecutarse en todas las chips de Nvidia compatibles. Luego, utilizando un NIM, los desarrolladores pueden ejecutar eficientemente el modelo en sus propios servidores o servidores en la nube de Nvidia sin un largo proceso de configuración.

“En mi código, donde estaba llamando a OpenAI, reemplazaré una línea de código para que apunte a este NIM que obtuve de Nvidia en su lugar,” dijo Das.

Nvidia dice que el software también ayudará a la IA a ejecutarse en laptops equipadas con GPU, en lugar de en servidores en la nube.