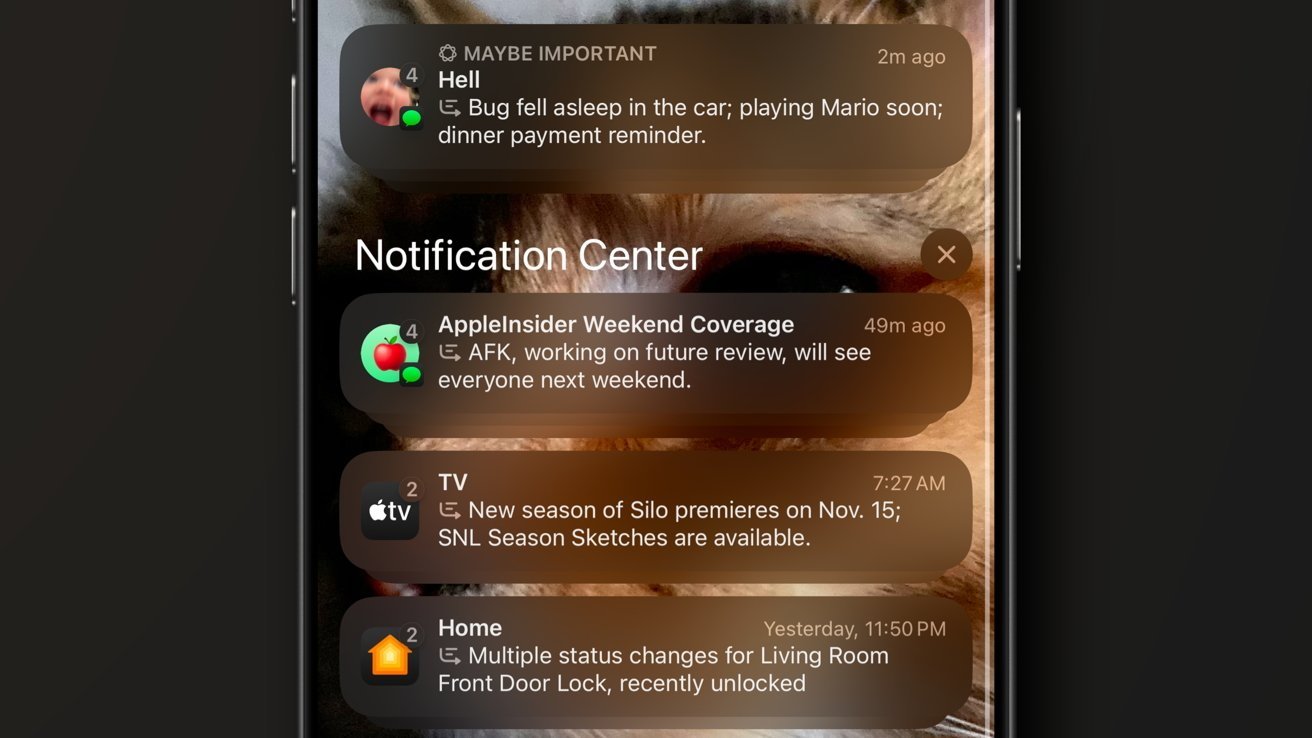

Ejemplos de resúmenes de notificaciones en iOS 18.1

La BBC del Reino Unido se ha quejado de la función de resumen de notificaciones de Apple en iOS 18 por fabricar completamente la esencia de un artículo. Aquí está lo que sucedió y por qué.

La introducción de Apple Intelligence incluyó características de resumen, ahorrando tiempo a los usuarios al ofrecer puntos clave de un documento o una colección de notificaciones. El viernes, el resumen de notificaciones fue un gran problema para un importante medio de comunicación.

La BBC ha presentado una queja a Apple sobre cómo la función de resumen interpreta erróneamente los titulares de noticias y llega a la conclusión incorrecta al producir resúmenes. Un portavoz dijo que se contactó a Apple para “plantear esta preocupación y solucionar el problema”.

En un ejemplo ofrecido en su queja pública, una notificación que resume las noticias de la BBC afirma “Luigi Mangione se dispara a sí mismo”, refiriéndose al hombre arrestado por el asesinato del CEO de UnitedHealthcare, Brian Thompson. Mangione, quien está bajo custodia, está muy vivo.

“Es esencial para nosotros que nuestras audiencias puedan confiar en cualquier información o periodismo publicado en nuestro nombre y eso incluye las notificaciones”, dijo el portavoz.

Las resúmenes incorrectos no son solo un problema para la BBC, ya que también ha sido víctima el New York Times. En una publicación de Bluesky sobre un resumen del 21 de noviembre, afirmaba “Netanyahu arrestado”, sin embargo, la historia era realmente sobre la Corte Penal Internacional emitiendo una orden de arresto contra el primer ministro israelí.

Apple se negó a hacer comentarios a la BBC.

Alucinando las noticias

Los casos de resúmenes incorrectos se denominan “alucinaciones”. Esto se refiere a cuando un modelo de IA produce respuestas no del todo precisas, incluso frente a conjuntos de datos extremadamente claros, como una noticia.

Las alucinaciones pueden ser un gran problema para los servicios de IA, especialmente en casos en los que los consumidores confían en obtener una respuesta directa y sencilla a una consulta. También es algo con lo que las empresas que no son Apple también tienen que lidiar.

Por ejemplo, las primeras versiones del IA Bard de Google, ahora Gemini, de alguna manera combinaron a Malcolm Owen, escritor de AppleInsider, con el difunto cantante del mismo nombre de la banda The Ruts.

Las alucinaciones pueden ocurrir en los modelos por diversas razones, como problemas con los datos de entrenamiento o el propio proceso de entrenamiento, o una aplicación incorrecta de patrones aprendidos a nuevos datos. El modelo también puede carecer de suficiente contexto en sus datos y sugerir una respuesta completamente correcta o hacer una suposición incorrecta sobre los datos de origen.

No se sabe exactamente qué está causando los problemas de resumen de titulares en este caso. El artículo fuente era claro sobre el autor de los disparos y no mencionaba nada sobre un ataque al hombre.

Este es un problema que el CEO de Apple, Tim Cook, entendió como un problema potencial en el momento de anunciar Apple Intelligence. En junio, reconoció que estaría “por debajo del 100%”, pero que seguiría siendo de “muy alta calidad”.

En agosto, se reveló que Apple Intelligence tenía instrucciones específicas para contrarrestar las alucinaciones, incluidas las frases “No alucines. No inventes información factual”.

También no está claro si Apple querrá o podrá hacer mucho sobre las alucinaciones, debido a su decisión de no monitorear lo que los usuarios ven activamente en sus dispositivos. Apple Intelligence prioriza el procesamiento en el dispositivo siempre que sea posible, una medida de seguridad que también significa que Apple no recibirá muchos comentarios sobre los resultados reales de los resúmenes.