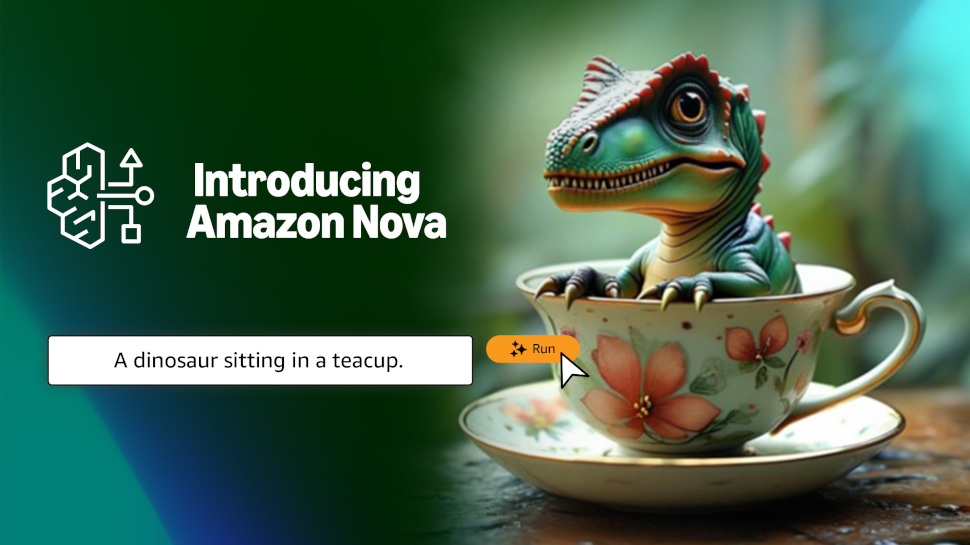

Amazon ha revelado nuevas herramientas de inteligencia artificial para la creación de imágenes y vídeos

Amazon Nova Canvas y Nova Reel buscan ayudar a los vendedores de comercio electrónico

Ambos nuevos modelos Nova planean lanzarse en 2025

Amazon ha anunciado nuevos modelos de generación de imágenes y vídeos mientras aumenta su lucha por convertirse en un gigante de la inteligencia artificial.

La empresa presentó Amazon Nova Canvas y Nova Reel en su evento AWS re:Invent 2024 en Las Vegas, con el CEO Andy Jassy revelando el lanzamiento como parte de una nueva serie de modelos de IA llamada Nova.

Ambos nuevos modelos estarán disponibles a mediados de 2025, y los lanzamientos llevarán a Amazon a competir directamente con empresas como OpenAI y Grok en lo que se refiere a la creación de imágenes y videos.

Amazon Nova Canvas y Reel

Los nuevos modelos tienen como objetivo inicial los vendedores y otros usuarios de la plataforma de comercio electrónico de Amazon, permitiéndoles crear contenido multimedia de forma rápida y económica para enriquecer sus páginas.

Amazon no reveló muchos detalles sobre las nuevas ofertas, pero sí mencionó que Nova Canvas permitirá a los usuarios crear y editar imágenes utilizando entradas de texto en lenguaje natural, y Nova Reel podrá proporcionar videos de calidad de estudio, con características como control de movimiento de cámara, rotación de 360 grados y zoom.

En una publicación en el blog anunciando la noticia, la empresa señaló que los clientes en su plataforma de Amazon Ads que utilizan los nuevos modelos anunciaron cinco veces más productos y el doble de imágenes por producto anunciado, ampliando su alcance a compradores de todo el mundo.

Mirando hacia el futuro, Jassy también reveló que Amazon lanzará un modelo de generación de voz a voz a principios de 2025, seguido por un modelo “Any-to-Any” a mediados de 2025.

El primero podrá analizar y comprender la entrada de voz en tiempo real en lenguaje natural, con la capacidad de interpretar señales verbales y no verbales como el tono y la cadencia, para responder de manera natural y parecida a un humano.

El segundo, que Jassy describió como un verdadero modelo multimodal a multimodal, podrá recibir texto, imágenes, audio y video, antes de emitir la salida en el modo requerido.

También te puede interesar

“