Debido a que los modelos de lenguaje grandes operan utilizando estructuras similares a neuronas que pueden vincular muchos conceptos y modalidades diferentes, puede ser difícil para los desarrolladores de IA ajustar sus modelos para cambiar el comportamiento de los modelos. Si no sabes qué neuronas conectan qué conceptos, no sabrás qué neuronas cambiar.

El 21 de mayo, Anthropic creó un mapa detallado de los intrincados trabajos internos de la versión ajustada de su modelo Soneto 3.0 de Claude 3. Con este mapa, los investigadores pueden explorar cómo los puntos de datos similares a neuronas, llamados características, afectan la salida de una IA generativa. De lo contrario, las personas solo pueden ver la salida en sí misma.

Algunas de estas características son “relevantes para la seguridad”, lo que significa que si las personas identifican de manera confiable esas características, podría ayudar a ajustar la IA generativa para evitar temas o acciones potencialmente peligrosos. Las características son útiles para ajustar la clasificación, y la clasificación podría impactar en los prejuicios.

¿Qué descubrió Anthropic?

Los investigadores de Anthropic extrajeron características interpretables de Claude 3, un modelo de lenguaje grande de última generación. Las características interpretables pueden traducirse en conceptos comprensibles por los humanos a partir de los números que el modelo puede leer.

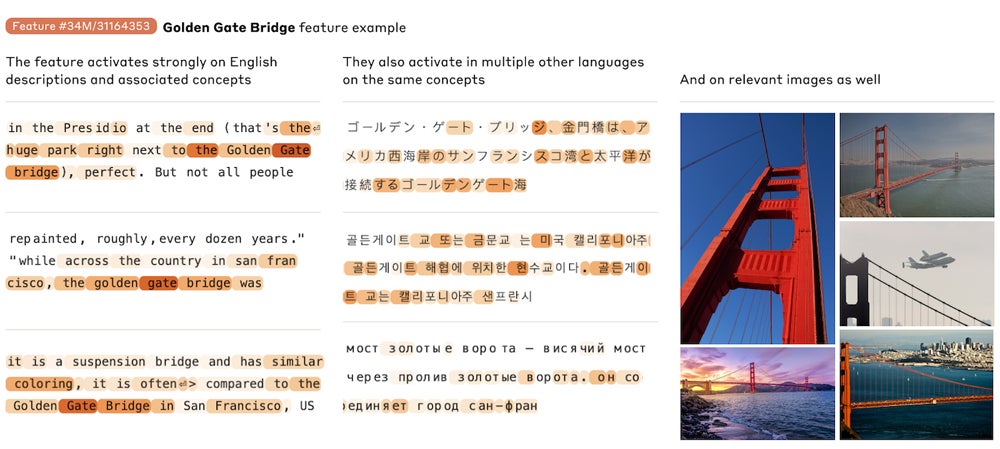

Las características interpretables pueden aplicarse al mismo concepto en diferentes idiomas y tanto a imágenes como a texto.

Examinar las características revela qué temas considera el modelo de lenguaje grande que están relacionados entre sí. Aquí, Anthropic muestra una característica particular que se activa en palabras e imágenes relacionadas con el Puente Golden Gate. Imagen: Anthropic

“¡Nuestro objetivo principal en este trabajo es descomponer las activaciones de un modelo (Claude 3 Sonnet) en piezas más interpretables!”, escribieron los investigadores.

“¡Una esperanza para la interpretabilidad es que pueda ser una especie de ‘conjunto de pruebas para la seguridad, lo que nos permite saber si los modelos que parecen seguros durante el entrenamiento serán realmente seguros en el despliegue!”, dijeron.