El próximo procesador gráfico de última generación de Nvidia para inteligencia artificial, llamado Blackwell, costará entre $30,000 y $40,000 por unidad, según informó el CEO Jensen Huang a Jim Cramer de CNBC.

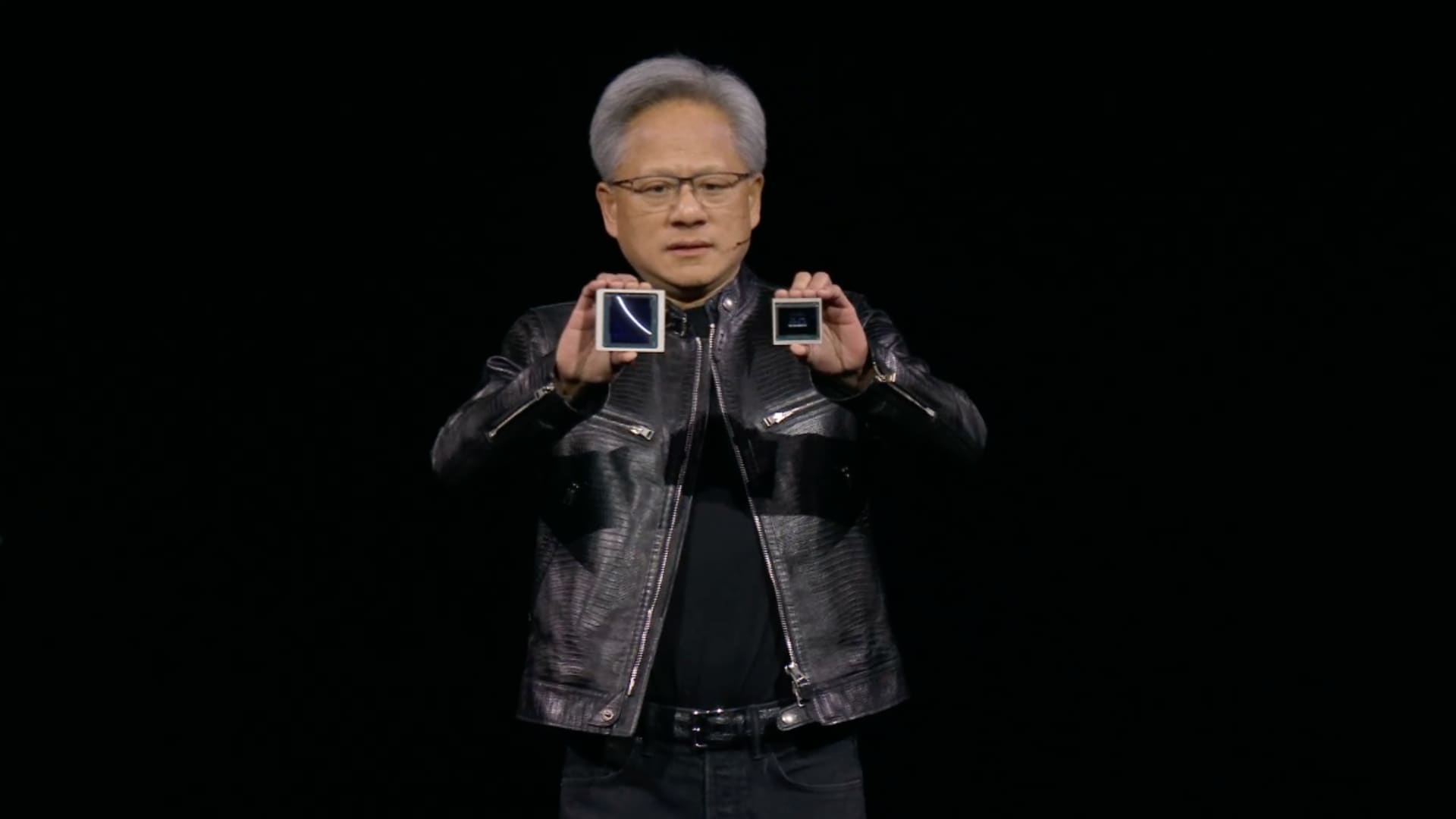

“Esto costará entre $30,000 y $40,000 dólares”, dijo Huang, mostrando el chip Blackwell.

“Tuvimos que inventar nueva tecnología para hacerlo posible,” continuó, estimando que Nvidia gastó alrededor de $10 mil millones en costos de investigación y desarrollo.

El precio sugiere que el chip, que probablemente estará en alta demanda para el entrenamiento e implementación de software de IA como ChatGPT, tendrá un precio en un rango similar a su predecesor, el H100, o la generación “Hopper”, que costaba entre $25,000 y $40,000 por chip, según estimaciones de analistas. La generación Hopper, introducida en 2022, representó un aumento significativo en el precio de los chips de IA de Nvidia en comparación con la generación anterior.

El CEO de Nvidia, Jensen Huang, compara el tamaño del nuevo chip “Blackwell” con el chip H100 “Hopper” actual en la conferencia de desarrolladores de la empresa, en San José, California.

Nvidia anuncia una nueva generación de chips de IA aproximadamente cada dos años. Los más recientes, como Blackwell, generalmente son más rápidos y eficientes energéticamente, y Nvidia utiliza la publicidad alrededor de una nueva generación para obtener pedidos de nuevas GPUs. Blackwell combina dos chips y es físicamente más grande que la generación anterior.

Los chips de IA de Nvidia han impulsado un triplete en las ventas trimestrales de Nvidia desde el auge de la IA que comenzó a fines de 2022 cuando se anunció ChatGPT de OpenAI. La mayoría de las principales empresas y desarrolladores de IA han estado utilizando el H100 de Nvidia para entrenar sus modelos de IA durante el último año. Por ejemplo, Meta está comprando cientos de miles de GPUs Nvidia H100, dijo este año.

Nvidia no revela el precio de lista de sus chips. Vienen en varias configuraciones diferentes y el precio que un consumidor final como Meta o Microsoft podría pagar depende de factores como el volumen de chips comprados o si el cliente compra los chips directamente a Nvidia a través de un sistema completo o a través de un proveedor como Dell, HP o Supermicro que construye servidores de IA. Algunos servidores se construyen con hasta ocho GPUs de IA.

El lunes, Nvidia anunció al menos tres versiones diferentes del acelerador de IA Blackwell, un B100, un B200 y un GB200 que combina dos GPUs Blackwell con una CPU basada en Arm. Tienen configuraciones de memoria ligeramente diferentes y se espera que se envíen más adelante este año.